Joakim Melin

Elon Musk köper inte Twitter trots allt ⚓

Still, one should remain open to the possibility that he was kidding when he first signed the deal. “Elon Musk had a well-thought-out business and financial plan for Twitter that worked in the economic conditions of early April 2022, but conditions have changed and the model no longer works” does not strike me as the most plausible description of what is going on here. “Elon Musk whimsically thought it might be fun to own Twitter, so he signed a merger agreement without taking it too seriously and then lost interest a week later” feels more true to the situation. My first reaction to his proposal to buy Twitter, that it was a joke, may have been the correct one. He was just a lot more committed to the bit than I expected.

På många sätt är detta det bästa sättet denna affär kunde slutat på. Musk får sig en påminnelse om den verklighet han annars inte tycks tillbringa nämnvärt mycket tid i, Twitters ägare får sig en påminnelse om varför de kanske inte skulle ha investerat i bolaget från första början, och resten av världen kan fortsätta använda Twitter som vanligt (och slippa vissa orange-färgade köttsäckars närvaro).

(via John Gruber)

FTP-servern är tillbaka ⚓

Efter att min Proxmox-installation på min gamla server brakade ihop ordentligt i vintras så flyttade jag webbsajter (inklusive denna) till en virtuell server hos OVH:s datacenter i London. Kvar på servern blev det dock en hel del grejer som jag gärna hade haft kvar i någon form, och en av dessa saker var min FTP-server som innehåller allsköns grejer för retrodatorer, gamla BBS-system och annat.

Idag tog jag mig för att slutligen åka den dryga milen mellan mig och serverhallen där maskinen stod avstängd och hämtade hem den, kopplade upp den på mitt lokala nät hemma och lite hackande för att ta mig in i Proxmox-installationen och en del filkopierande senare (en kopiering som fortfarande pågår när detta skrivs) är nu min FTP-server igång igen, i fortsättningen under namnet ftp.melin.org. Namnet till trots så är det fullt möjligt att det inte går att ansluta till servern via just FTP på grund av begränsningar jag inte har något inflytande över – testa gärna och rapportera vad du kommer fram till.

FTP-servern körs på en virtuell maskin i mitt PiMox-kluster och filerna ligger på min NAS.

Mycket nöje.

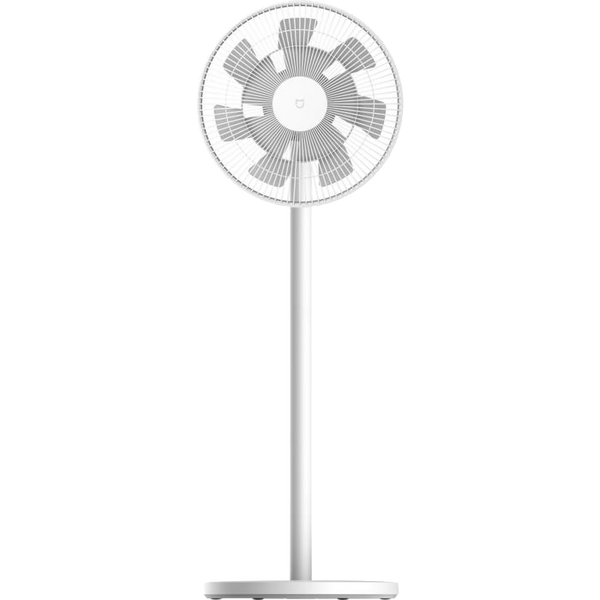

Mi Smart Standing Fan 2 Lite ⚓

Att det råder värmebölja i landet har väl knappast undgått någon. Jag testade att lösa problemet genom att köpa tre små fläktar som man fyllde på med isvatten och även om de entusiastiskt (med en matchande hög och störande ljudnivå) försökte kyla ner lägenheten så tog kylvattnet slut ganska snabbt och så värst stor skillnad blev det egentligen inte.

Dags att kalla in det lite grövre artilleriet, således.

Jag har redan en portabel AC, en sån där som drar 930 watt och som skickar ur sig mer varm luft än kall, och den har fått jobba under begränsade stunder (med tanke på elpriset i det här landet…) och resterande tiden har vi vackert fått lida… och svettas. Nu handlade det om att skaffa fläktar som kan trycka in luften i lägenheten från de öppna fönstren till där vi faktiskt sover. Givetvis vore det ju dumt om dessa inte gick att styra från mobiltelefonen, så jag köpte tre stycken Mi Smart Standing Fan 2 Lite.

Precis som allt annat som Xiaomi tillverkar så fungerar det inte med Homekit, men det fungerar med deras hyfsat vedervärdiga applikation för iOS och det får duga. Skillnaden mellan den här modellen och den 200 kronor dyrare Mi Smart Standing Fan 2 är att den dyrare kan forcera mer luft i den riktning du vill ha den. Jag kan inte påstå att Mi Smart Standing Fan 2 lite har något problem med den saken, åtminstone inte i de rum där de tre fläktarna placerats.

Installation

Inte för att solen inte har sina fläckar – Mi Smart Standing Fan 2 lite har en del av dem. Monteringen av fläkten gick snabbt och var tämligen enkel även om draget att trycka ljusgrå text på vit bakgrund i manualen kanske inte var det smartaste ur läsbarhetssynpunkt.

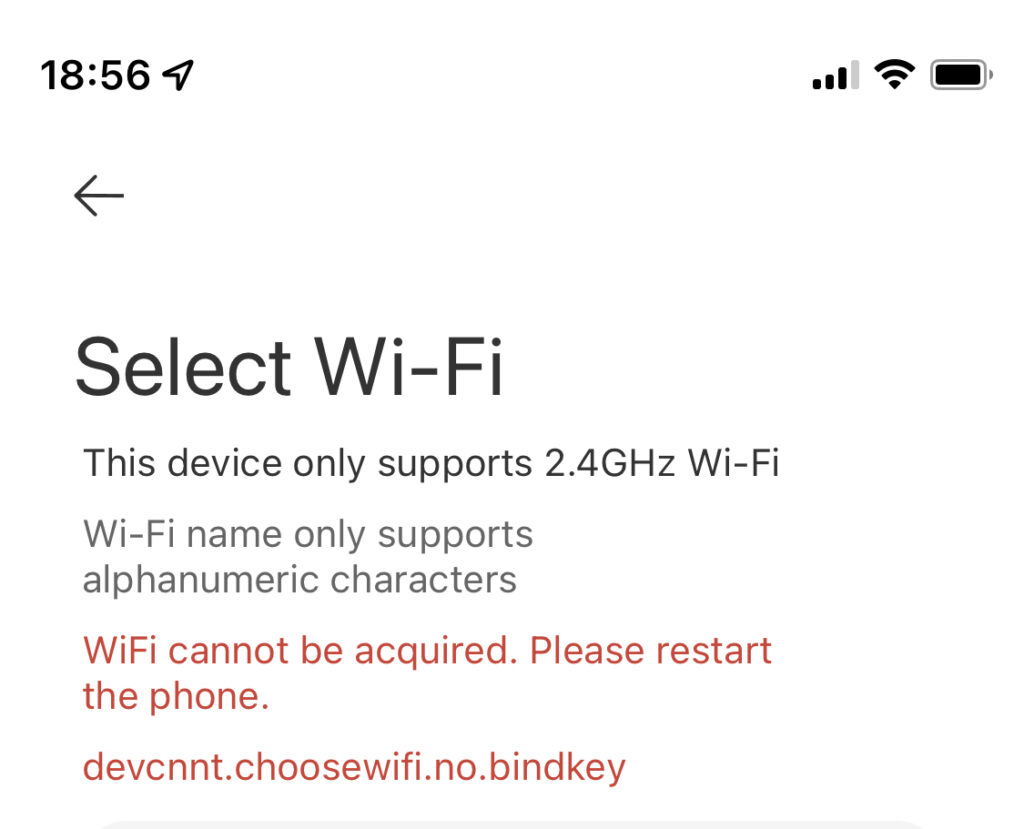

Installationen till mitt wifi-nät var däremot inget vidare. Fläkten har inget stöd för Bluetooth så jag kunde inte installera den genom att bara hålla telefonen nära fläkten (trots att applikationen var väldigt tydlig med att jag skulle kunna göra just det). Det fanns heller ingen etikett jag kunde scanna in med telefonens kamera varför jag fick göra installationen manuellt.

I praktiken går det till så att man ser till att fläkten är fabriksåterställd (vilket bekräftas av ett högljutt pip från fläkten… dessa pip går tack och lov att slå av sen) och efter det uppmanas man av applikationen att ansluta telefonen till fläktens egna ad-hoc-wifi som den skapar. Det är enkelt. Det knepiga är när applikationen ändå inte kan ansluta till fläkten i fråga och man får inga vettiga felmeddelanden utöver dessa:

Det visar sig efter lite testande att man måste ge Xiaomi Home-applikationen rätten att komma åt ditt lokala nätverk. När man väl gjort det så ansluter fläkten snällt till wifi-nätverket.

Mi Smart Standing Fan 2 lite stödjer för övrigt endast 2,4GHz wifi-nät och inget annat, vilket känns lite år 2005 men det fungerar åtminstone hyfsat. Ett par gånger efter installation har jag haft problem att styra fläkten från appen men efter att den stått och snurrat i ett dygn i sträck så har problemen upphört, åtminstone i skrivande stund.

Design och funktion

Designen hade inte fått en designer på Apple att skämmas för sig. Det är vitt, diskret och lysdioderna på fläkten är fina att titta på.

En ordentlig fördel med Mi Smart Standing Fan 2 lite är hur tyst den är. Jag är inte överdrivet ljudkänslig men jag vill å andra sidan inte ligga och lyssna på en högljudd fläkt hela nätterna, men med Mi Smart Standing Fan 2 lite kan jag ha den på sin lägsta fläkthastighet och utan problem sova i samma rum. Efter att ha legat i princip sömnlös den senaste veckan fick jag inatt sova ordentligt och bekvämt så det har jag den här fläkten att tacka för.

Jag är nöjd med köpet. De här fläktarna löser problemet och givetvis är hela wifi-kopplingen rätt fånig och på många sätt helt onödig men är man en prylnörd så är man. En vacker dag kanske de går att köra med Homekit, vad vet jag…

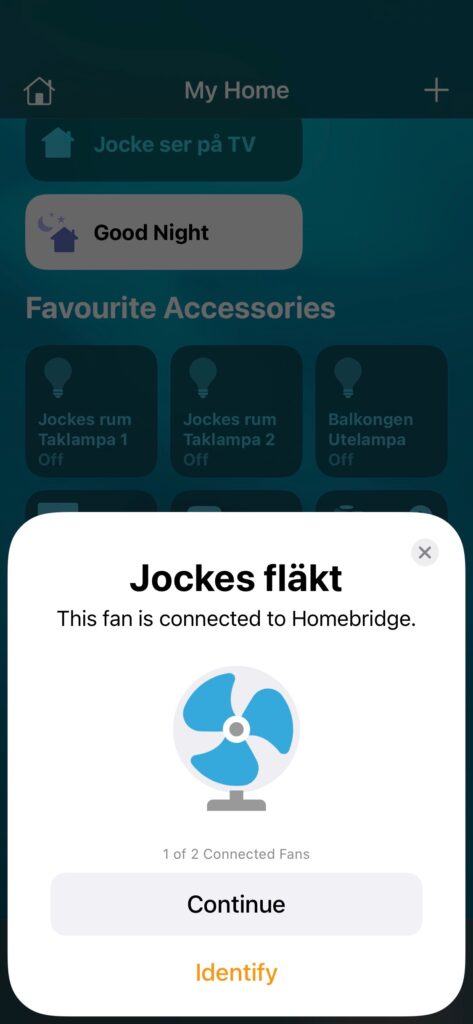

Tillägg 2022-07-07: Jodå, de kan prata Homekit… om man kopplar dem via Homebridge vilket visar sig fungera utmärkt:

Man behöver det här scriptetför att hämta ut tokens från alla enheter man vill ansluta till Homebridge (tack Victor) för tipset. Detta fungerar faktiskt så pass bra så jag överväger att ta bort Xiaomis applikation, som verkligen inte har någon plats i ett civilicerat samhälle.

BMÅ, avsnitt 314: Darth Vaders prisbasbelopp ⚓

Det är sommar och man kan tycka att det inte finns så mycket att prata om. Tänk så fel man kan ha. Denna vecka tog Christian semester och min namne, den eminente Joakim Ewensson, gästade podden, där vi pratar om mikrofoner, Youtube-skapande, myser över våra M1-Mac:ar och konstaterar att Obi-Wan Kenobi-serien inte var så dum ändå.

Mer läsning (och lyssning) här.

Ur arkivet: Den sorgliga sagan som är Apple:s support – the never ending story ⚓

Jag skrev detta i oktober 2004, drygt ett år efter att jag köpt en sprillans ny 12" Powerbook G4:

För en tid sen så lade batteriet i min 12" PowerBook av totalt. Jag fick kanske ut 30 minuters laddning ur ett batteri som inte ens var ett år gammalt så jag ringde Apple:s Support, fick för tredje gången förklara att jo, jag har AppleCare-paket till PowerBook:en men ni har reggat paketet på min gamla G3 PowerBook som jag inte äger längre! (de har lovat att fixa detta, för övrigt. Jag har faxat in pappret med min aktiveringskod för Apple Care till supporten tre gånger nu…).

Det är snart 18 år sedan jag skrev detta. Hade helt glömt bort det men det är kul att titta tillbaka på ett Apple som (förhoppningsvis, och samtidigt tyvärr) inte finns längre. Att jag skrev som en kratta på den tiden kan vi väl lämna därhän hoppas jag…

© 2000 - 2025 Joakim Melin.

Prenumerera på bloggen via Mastodon.