Joakim Melin

Homepod ⚓

När Apple lanserade Homepod i februari 2018 var det efter några år med framgångar för konkurrenter som Google och Amazon med sina röststyrda assistenter som exempelvis Amazon Echo. Givetvis ville Apple in på den marknaden och precis som Apple (nästan) alltid gör så inväntar de vad konkurrenterna gör först och sedan lanserar de en konkurrerande produkt som gör det och lite till, givetvis snyggare förpackat och enklare att använda.

Det fungerade för Macintosh, iPod, iPhone och iPad. Apple Watch är undantaget då Apple i praktiken skapade denna marknad och få, om ens några, konkurrenter kunde (eller kan) hänga på Apples rasande utveckling av den “smarta” lilla armbandsdatorn.

Givetvis borde Apples framgångsrecept fungera även för Homepod? Produkten är mindre än vad man kan tro när man tittar på bilder av den, designen är närmast oklanderlig och precis som Apple brukar göra så går de sin egen väg i ett antal avseenden. Men produkten blev inte den framgång som Apple hade hoppats på och den modell jag skriver om här lades ned i mars i år, 2021. Apple har för övrigt fortsatt släppa mjukvaruuppgraderingar och nya funktioner inbyggda i även den “stora” modellen av Homepod, men jag återkommer till det senare.

Varför Homepod?

När jag ställdes inför att köpa en ny ljudanläggning till min TV och till min AppleTV 4K, då jag ledsnat på att lyssna på det usla ljudet från de inbyggda högtalarna, så tittade jag först på ett antal ljudlimpor från Sonos, exempelvis Sonos Beam, och andra tillverkare som Sony, Onkyo med flera. Problemet med dessa tillverkare var att de endast kan kommunicera trådlöst via Airplay 2-protokollet, vilket endast ger stereoljud.

Ett annat alternativ är att via HDMI-anslutningen mellan AppleTV 4K och din TV och en funktion kallad Audio Return Channel, ARC, skicka ljudet från en Apple TV 4K via en TV som stödjer ARC till en ljudlimpa som också är ansluten till din TV via HDMI och på så sätt få Dolby Atmos-ljud från de filmer som stödjer det. Det hade inneburit att jag måste köpa en nyare TV med ARC inbyggt vilket jag inte hade lust med då jag är nöjd med den TV jag redan har.

Prislappen för en Sonos Beam och en ny TV skulle landa på närmare 15000 kronor, och det är utan en basmodul vilket närmast är ett krav då Sonos Beam inte har överdrivet bra basljud. En basmodul från Sonos kostar närmare 8000 kronor när detta skrivs, så det är rätt enkelt att räkna ut att detta skulle bli en kostsam affär.

Så jag började titta på Homepod. Jag hade aldrig hört hur en Homepod låter men läste flera recensioner som alla gav samma intryck: Homepod har ett sjukt bra ljud, i synnerhet med tanke på sin storlek. En annan sak som snart stod klar för mig var att man var tvungen att ha två för att få en bra ljudbild när man använder Homepod ihop med en TV. Ljudet från en enda Homepod är inte i stereo, men de totalt sju diskanthögtalarna och en bashögtalare, som alla drivs av varsin förstärkare inne i denna lilla högtalare. Tillsammans med totalt sex mikrofoner för Siri-kommandon så får man helt enkelt säga att Apple packade Homepod full med hårdvara, vilket inte märks på dess storlek men definitivt på dess vikt på 2,5 kilo styck.

Eftersom diskanthögtalarna sitter i en cirkel kan Homepod med hjälp av A8-processorn som sitter inbyggd i den (samma processor som satt i exempelvis iPhone 6) och en aktiv avancerad ljudmätning räkna ut hur nära Homepod stod en vägg och hur de åtta diskanthögtalarna ska skicka ut ljudet högtalare för högtalare. Det låter ruggigt bra för en enda högtalare men ska man verkligen få en komplett ljudbild, i Dolby Atmos eller endast i stereo, krävs två Homepod, vilka kostade drygt 4000 kronor styck vid lanseringen. När jag bestämde mig för att köpa två Homepod så fick jag gå via eBay för att få tag i dem vilket kostade 3500-4000 kronor styck med frakt, tullavgifter med mera.

Installation

Högtalarna köptes från två olika försäljare och båda kom i rymdgrått, vilket jag tycker är en snygg färg på ett par högtalare. Dock kom högtalare nummer två några veckor efter den första så jag hann bekanta mig med Homepod, uppgradera den och konfigurera den (och stänga av Siri). När högtalare nummer två kom så fick jag först uppgradera den innan jag kunde para ihop dem i ett stereopar.

Det första intrycket av ljudkvaliteten var när jag hade ställt den första högtalaren på skrivbordet framför min dator, kopplat in den via en adapter som konverterade strömkontakten från amerikansk standard till europeisk dito (Homepod accepterar 110-220 volt av sig själv så ingen transformator behövs) och sedan hörde jag Homepods uppstartsljud. Fanns det några frågetecken rörande hur mycket basljud som Homepod kunde skicka ur sig så rätade de ut sig till utropstecken för skrivbordet vibrerade kraftigt.

Användning

Efter att Homepod nummer två anlänt från USA och jag kopplat ihop dem så stod de på mitt skrivbord rätt länge och jag använde dem dagligen som högtalare till min Mac mini via Airplay 2 eller så spelade jag musik genom dem från min iPhone, även det via Airplay 2. Ljudkvaliteten har jag definitivt inget att klaga på, det låter fantastiskt och det är närmast otroligt att så små högtalare kan producera så pass bra ljud som de faktiskt kan och dessutom över en trådlös länk.

Det finns nämligen inga fysiska ljudingångar på Homepod, all kommunikation är trådlös över Bluetooth eller Wi-fi (802.11a/b/g/n/ac) men Homepod är inte bara en “dum” högtalare med röstassistenten Siri inbyggt utan den kan också sköta uppspelning av musik från Apple Music helt på egen hand. Startar du en uppspelning från musikapplikationen i din iPhone och sedan skickar ljudet till Homepod så kan du därefter avsluta musikapplikationen i telefonen, uppspelningen fortsätter ändå. Detta är givetvis coolt men också förvirrande när man exempelvis vill stoppa uppspelningen av en låt och öppnar musikapplikationen i en iPhone och ser att ingen musik spelas från den.

Detta är helt och hållet på grund av att all kommunikation med Homepod i Apples värld ska ske via Siri, inte via din iPhone, iPad eller liknande. men Siri i Homepod förstår inte svenska och jag gillar inte att ha aktiva enheter som lyssnar på allt som sägs i mitt hem och sedan, utan att jag har kontroll över det, kan skicka detta över Internet till någon server någonstans. Detta är varför jag inte har några digitala röstassistenter i mitt hem utöver Homepod, och i mina Homepod-högtalare är Siri avaktiverat.

Detta hindrar givetvis inte Apple att efter varje uppgradering av mjukvaran i Homepod aktivera Siri igen utan att säga något om det, något jag upptäckte när jag såg på en Youtubefilm på en annan dator 4-5 meter från mina Homepod-högtalare. I Youtube-filmen sa någon “Hey Siri, take a screenshot!” och helt plötsligt hör jag mina högtalare bekräfta att en skärmbild ska tas och två sekunder senare dyker det upp en skärmbild från min iPhone 11 i telefonen. Siri är nu avslaget igen.

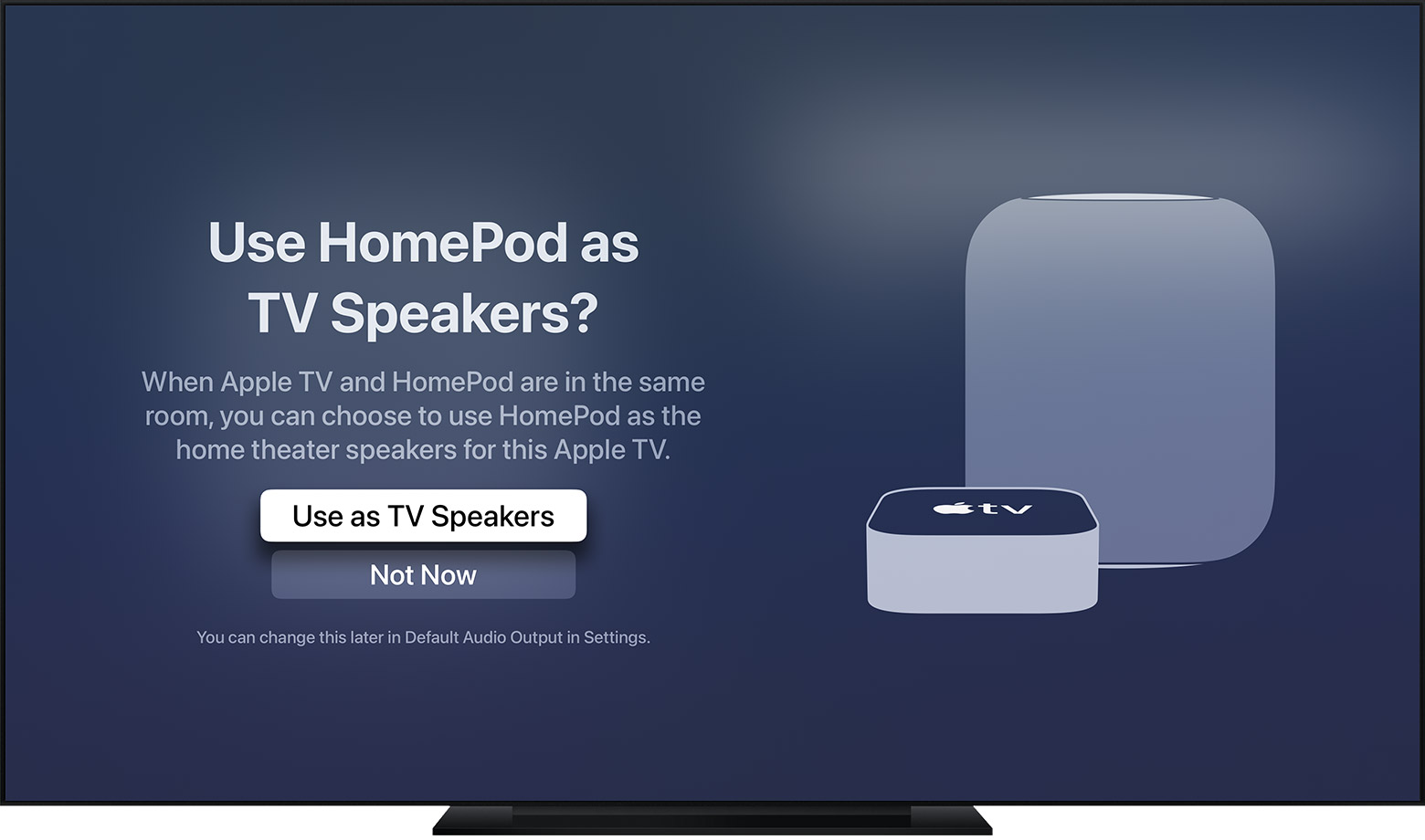

Att koppla ihop två Homepod i en parkonfiguration till en AppleTV 4K är inte svårare än att välja paret som ljudutgång i gränssnittet för AppleTV 4K och sedan kommer ljudet ut den vägen. Som grädde på tårtan får man också stöd för Dolby Atmos och, efter uppgraderingen till version 11.2.5 av programvaran, stöd för HDMI ARC eller eARC vilket innebär att man numera kan ansluta exempelvis en Bluray-spelare till din TV via HDMI och sedan skicka ljudet från TV:n till AppleTV 4K och vidare ut till Homepod-högtalarna.

Homepod var inte billiga att köpa, ens nu när Apple slutat tillverka och sälja den här modellen. Mina exemplar hade för övrigt handböcker med som var tryckta år 2018 vilket antyder att de antingen köptes när de lanserades eller precis när Apple meddelat att de slutat säljas. Troligen är det senare alternativet det troligare eftersom båda exemplaren leverades i sina orginalkartonger i nyskick, och det har rapporterats att de som beställt Homepod från Apple Store efter att Apple lagt ner tillverkningen av dem också fått exemplar som tillverkades 2018. Apple överskattade uppenbarligen efterfrågan på marknaden.

Detta till trots har den första Homepod-modellen sålt någonstans mellan 1-3 miljoner exemplar och de som äger dem svär vid dem. Jag är numera en av dem.

Lilla medelålderskrisen ⚓

Idag var det på sätt och vis något som gick sönder inom mig. När jag såg min Volvo XC70 rulla iväg med en ny ägare så vet jag inte riktigt vad jag kände, annat än att det var en förändring som måste göras av kostnadsskäl och att jag med handen på hjärtat inte behöver ha en stor, tung Volvo-kombi med dragkrok och fyrhjulsdrift. Om några månader bor jag inne i Vallentuna igen i en bostadsrätt med asfalterad parkering och jag kommer inte åka till Byggmax för att köpa hem tio betongplintar till något bygge.

Jag har kört Volvo XC70 de senaste nio åren. Först denna och sedan denna. Den första rullade 60000 mil innan jag bytte in den och samtidigt köpte den senare. För mig har XC70, hur löjligt det må låta, blivit en liten del av mig. Jag kan de här bilarna utan och innan och varje gång man reparerat eller bytt en del på dem, oavsett om det är strålkastarlinser eller bromsok, så har det alltid känts som ett stort steg framåt, vilket inom några månader ofta besvarades av bilen med att skicka mig två steg bakåt igen med ännu något som måste bytas eller repareras på den.

Jag har gladeligen gjort detta arbete på båda bilarna eftersom de trots sina tillkortakommanden (som mest kan skyllas på deras ålder och i fallet med den senare bilen på bristade underhåll av tidigare ägare) eftersom detta är bilar som aldrig lämnat mig strandade vid vägkanten, som när de hamnat i diket låtit mig köra upp dem igen utan minsta bråk och som hållit mig varm på vintern och kall på sommaren.

Kort sagt: XC70 och jag gillar varandra. Men med det sagt så har det varit kostsamma affärer som slitit på både tålamod och plånbok.

Nu är det över. Idag hämtades bilen av en köpare som visste vad han gav sig in på. Jag fick så mycket betalt som jag ville ha och han betalade så mycket som han ville betala. Alla glada och nöjda.

Vad ska jag då köra i fortsättningen? Jag hade en lista över bilar jag var intresserad av (som jag också provkörde) och i takt med att ingen av dem egentligen mötte mina förväntningar (man blir lätt kräsen som Volvoman…) så växte desperationen en aning. Det jag dock visste var att jag inte skulle ha en vit bil, inte en BMW och troligen inte ens diesel.

Så jag köpte en vit BMW 320d Touring med automatlåda. En liten medelålderskris så här några år i förväg kanske? Bra fråga – jag är inte medelålders ännu, jag är heller inte en padelspelande mellanchef men jag har aldrig ägt en BMW och tänkte att det var dags att testa en modernare, tajtare, bil. Men det är en annan historia som jag får be att få återkomma till.

Migrera e-post från Exchange Server ⚓

Efter att ha börjat se över min privata serverpark så är det en sak som jag känt mig missnöjd med: min e-postserver. Det har med åren blivit allt mer komplicerat att köra egen e-postserver hemma på privat internetlina, även om man har en fast IP-adress, port 25 öppet och en korrekt reverse DNS-pekare mot sin e-postserver. Det är också, minst sagt, inte helt underhållsfritt att köra en Exchange Server – detta är som de flesta vet en smidig och trevlig lösning tills att man stöter på ett problem, exempelvis ett strömavbrott eller när servern ska patchas och det går åt skogen.

Så jag började fundera. Jag satt och jämförde priser på olika lösningar där jag låter ett annat företag hantera allt åt mig och jag tittade högt som lågt, från Exchange Online till Mailbox.org men det hela föll på att det skulle kosta mig 500-600 kronor i månaden, alltså 6000-7000 kronor om året, för att hantera e-post åt mig, mina barn och mina föräldrar. Det blev helt enkelt för dyrt, även om det varit oerhört bekvämt att bara kasta problemet på någon annan.

Således tillbaka till ritbordet. Jag ville ha något enklare än Exchange Server, som bygger på Linux, Postfix och andra programvaror som bygger på öppen programvara, som är duktiga på att skriva i loggfiler (och därmed är enkla att felsöka), som stödjer ActiveSync till enheter som kan använda det och som också erbjuder IMAP, vettig webbaserad e-postfunktion, kalender och kontaktsynkning till alla de plattformar jag använder dagligen (iOS, LinageOS, macOS och Linux). Efter en del rotande och funderande så föll valet på iRedmail som är en gratis paketering med alla dessa funktioner inbyggt från skalet. Den webbaserade kontrollpanelen är inte helt överdrivet imponerande såvida man inte vill betala 499 dollar per år för att få en fullfjädrad dito men gänget bakom iRedmail är ändå pass snälla så de noga dokumenterat hur man kan utföra de allra flesta administrationsgöromål i ett terminalfönster istället. Att de dessutom endast tar betalt via Paypal är, åtminstone i min bok, ett klart misstag.

Hur som haver, efter att jag tittat på olika leverantörer av en virtuell privat server (VPS) föll valet på OVH och en tusenlapp senare hade jag tecknat mig för tolv månaders abonnemang av en VPS med dubbla processorkärnor, fyra gigabyte internminne och 80 gigabyte hårddisk. Fyra gigabyte internminne är det gränsvärde som iRedmail-utvecklarna anger som en lägsta-nivå för en mindre e-postserver vilket jag anser att min är. Skulle det behövas mer är det bara att panga på fyra gigabyte till, men där är vi inte ännu.

iRedmail är därefter installerat, SSL-certifikatet är fixat med Let’s Encrypt (givetvis), domäner och användarkonton inlagda DKIM-nyckeln för respektive domän är genererad och inpetad i Amavisd.conf och DNS-tabellerna för varje domän är uppdaterad. Således är det dags att migrera e-posten från den gamla Exchange-servern till min nya fina server.

Det är, som det brukar heta, nu det “roliga” börjar.

Det är inte roligt

Nej, det är inte roligt att migrera e-post, i synnerhet när det är någon annans e-post man ska migrera. Men det måste göras och har man en gång öppnat dörren för att hantera e-post för kreti och pleti så får man vackert leva med att jobbet måste göras.

Hur som haver, det är egentligen inte så vansinnigt komplicerat, egentligen. Mycket tack vare att du nu får några tips som kommer göra det betydligt enklare för dig.

Först och främst: se till att IMAP-tjänsterna är aktiverade i din Exchange-server. Kolla i services.msc på servern om de är igång, om inte – starta dem.

Se därefter till att användarna har IMAP aktiverat som funktion för sina användarkonton. Har du inte aktivt slagit av detta brukar det vara aktivt som standard men dubbelkolla genom ECP.

Testa sedan att köra telnet till din e-postserver på port 143 eller 993. Om servern säger “hej hopp” och sedan väntar på input är det grönt ljus och du kan gå vidare i processen. Om den däremot “slänger på luren” och inte vill prata med dig alls så ska du läsa vidare i nästa punkt.

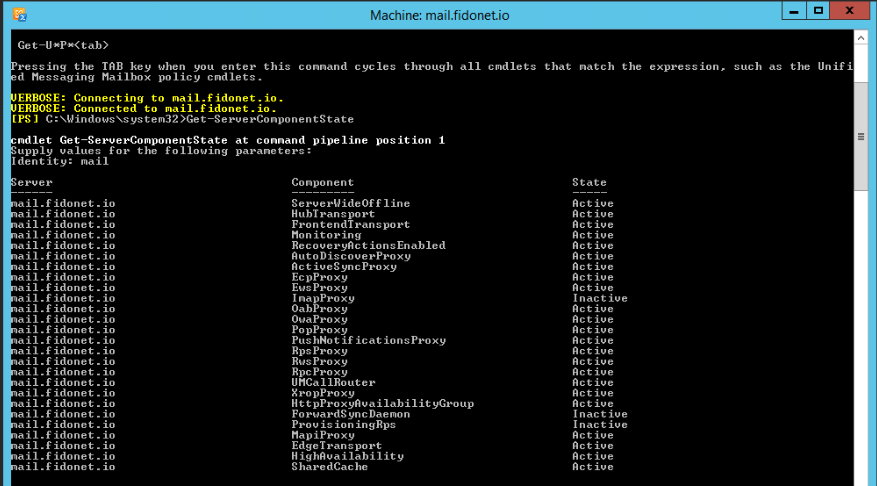

Detta är nästa punkt. Logga in via RDP med ett administratorkonto på din Exchange-server och öppna därefter EMC (Exchange Management Shell). Ge därefter kommandot Get-ServerComponentState och kolla noggrant om det finns tjänster som står som Inactive.

Ser det ut som bilden ovan, att ImapProxy står som Inactive så betyder det precis vad du tror – den kommer inte prata IMAP med dig. Lyckligtvis är det inte supersvårt att fixa. Ge följande kommando: Set-ServerComponentState -Identity SERVERNAMN -Component IMAPProxy -State Active -Requester HealthAPI

Kör sedan Get-ServerComponentState och se så ImapProxy står som aktiv och försök köra telnet till den igen på port 143 eller 993.

Ser allt bra ut kan du sätta igång att migrera.

Migreringsprocessen

Vi använder oss i denna guide av ett verktyg som heter Imapsync. Den gör precis vad namnet antyder, synkroniserar e-post mellan två olika servrar, eller två olika konton på samma server, via IMAP-protokollet. Det finns tonvis med information om hur man använder Imapsync, man kan köra det på Windows, Unix eller Linux med olika för- och nackdelar. Jag har valt att köra det på Linux därför att.

Installera Imapsync (på Linux och Unix kan du behöva kompilera det – läs på och fixa) och sedan skapar du två filer i den katalog du kör Imapsync från: pass1 och pass2. Varför undrar du? En titt på kommandoraden jag kör visar vad det hela handlar om:

imapsync --host1 server1 --ssl1 --user1 login --passfile1 pass1 --exclude Public Folders --host2 server2 --ssl2 --user2 login --passfile2 pass2

Förklaringsdags:

–host1 är den server du migrerar från.

–host2 är den server du migerar till.

–ssl1 anger att Imapsync ska prata SSL med servern du migrerar från.

–ssl2 anger att Imapsync ska prata SSL med servern du migerar till.

–user1 är inloggningsnamnet på den användare på host1 du ska migrera till användaren på host2.

–user2 är inloggningsnamnet på den användare på host2 du ska migrera från användaren på host1.

–passfile1 är lösenordet för den användare på host1 du ska migrera till användaren på host2.

–passfile2 är lösenordet för den användare på host1 du ska migrera från användaren på host1.

–exclude Public Folders innebär att jag inte vill synkronisera över innehållet i några publika foldrar på Exchange Servern. Det finns inget där på min server men det kan ställa till det i synkroniseringen så mitt råd är att skippa dem.

Anledningen till att man sätter lösenorden i en fil är att de ofta innehåller knepiga tecken och det kan ställa till det i kommandoraden i Linux. Om du kör Imapsync och inte anger några parametrar alls så kommer du se alla parametrar du kan köra. De är många och de flesta behöver du nog inte men det kan vara värt att kolla på.

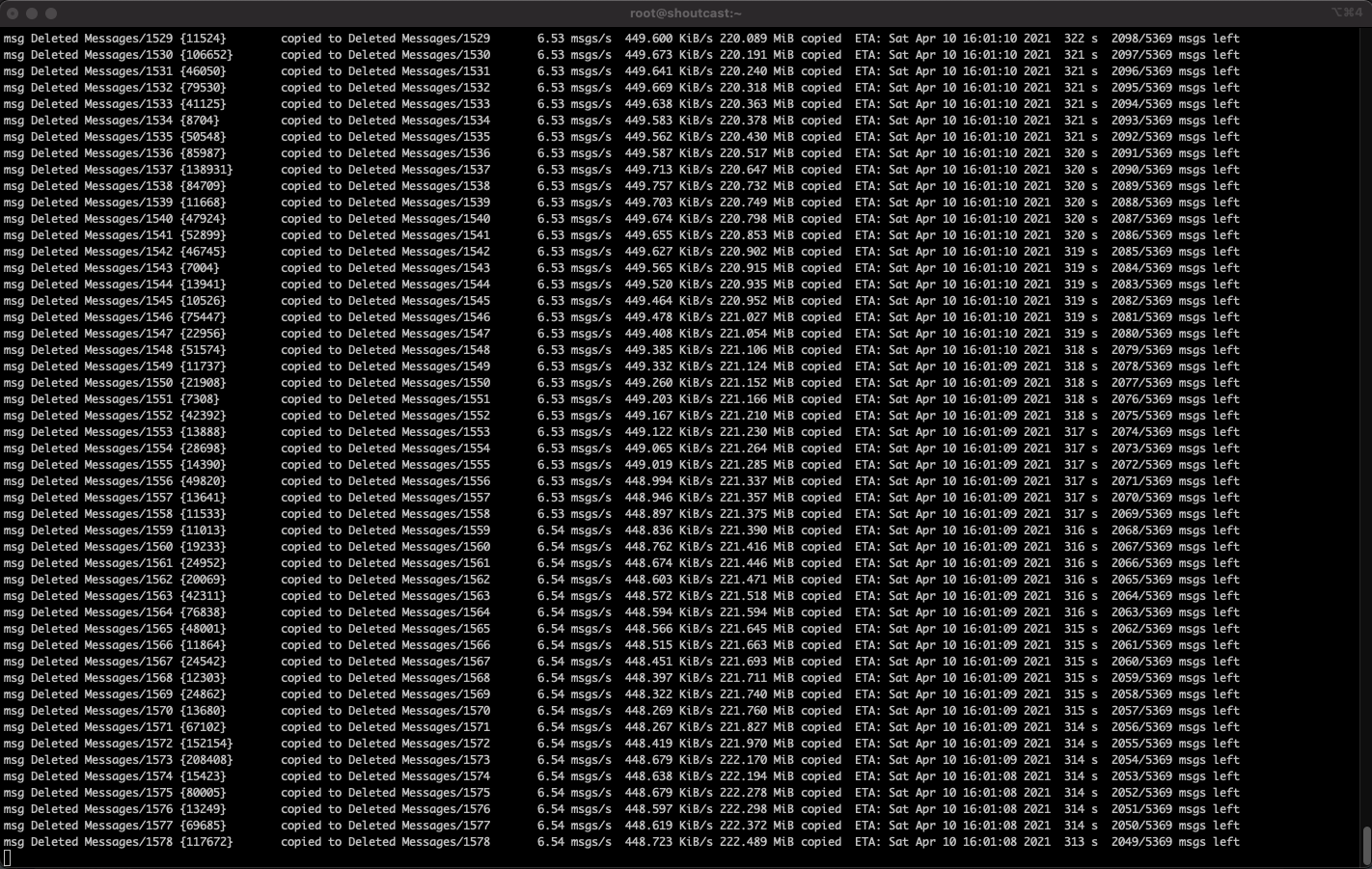

Om allt fungerar kommer e-posten att synkroniseras över mellan de två servrarna. Beroende på hur snabb internetanslutning du har och hur mycket e-post som ska slangas över så kan det ta några minuter eller så kan det ta… fler minuter. Ett konto jag migrerade med 476 megabyte e-post, drygt 7000 brev, tog drygt 17 minuter att överföra med ett snitt på drygt sex meddelanden i sekunden enligt Imapsync.

Har du fler användare är det bara att repetera processen tills du är klar. Se till att du håller ordning på lösenorden så kommer det fungera finemang.

Lycka till!

BMÅ 251: I bodelningen hade jag ett väggfäste ⚓

Avsnitt 251 av min, Fredriks och Christians podd diskuterar vi tunga ämnen som Fredriks fläktande jobbdator, Jockes knastrande labbkluster och Christians kärlek till Apples “Get a Mac”-kampanj.

Lyssna här vettja.

Preview-bilder med Jekyll ⚓

Webben har många roliga egenskaper numera. En sak som jag aldrig riktigt orkat kolla på tidigare är att kunna visa en preview-bild när man postar en länk i exempelvis iMessage, Mastodon, Facebook, Twitter, LinkedIn eller på någon annan webbsajt som stödjer att hämta hem en förhandsvisning från den sajt du länkat till. Detta kallas OpenGraph Link Preview och förhandsbilden är en del av massor av olika metadata du kan mata in i en bloggpost.

Jag är inte överdrivet intresserad av allt detta (ännu – jag kanske orkar rota vidare i detta senare) men det jag ville åstadkomma var att få fram dessa förhandsbilder i mina Jekyll-postningar på denna blogg (och senare på Björeman // Melin // Åhs-sajten).

Hur som helst, lite rotande och grävande senare lyckades jag få till det och i princip är det fyra steg du måste göra.

Lägg först till följande rad i _config.yml för din sajt:

plugins:

jekyll-seo-tag

Installera jekyll-seo-tag-pluginen genom att lägga till följande i din Gemfile för din Jekyll-sajt:

gem 'jekyll-seo-tag'

Kör sedan bundle install för att installera pluginen.

I ditt tema lägger du till följande tag precis innan </head>:

{{ seo }}

I mitt tema la jag detta i /_layouts/post.html, i ditt tema kan det vara någon annanstans.

I den bloggpost som du vill ha med förhandsbilden lägger du till följande i :

image:

path: /assets/jekyll_logo.png

height: 100

width: 100

Path pekar mot bilden du vill ha med i förhandsvisningen. Därefter är det bara att bygga och producera din blogg som vanligt så ska förhandsbilden visas som tänkt.

© 2000 - 2025 Joakim Melin.